※まだ書いていません。

VRXにバックレストをつけました。

VRXにサイドバッグサポートをつけました。

VRXにタンデムバーをつけました。

タンデムグリップ、グラブバー。

竜門狭に行ってきました。

※まだ書いていません。

展海峰・白浜海水浴場に行ってきました。

※まだ書いていません。

上五島に行ってきました。

※まだ書いていません。

長串山公園・鹿町ウィンドファームに行ってきました。

※まだ書いていません。

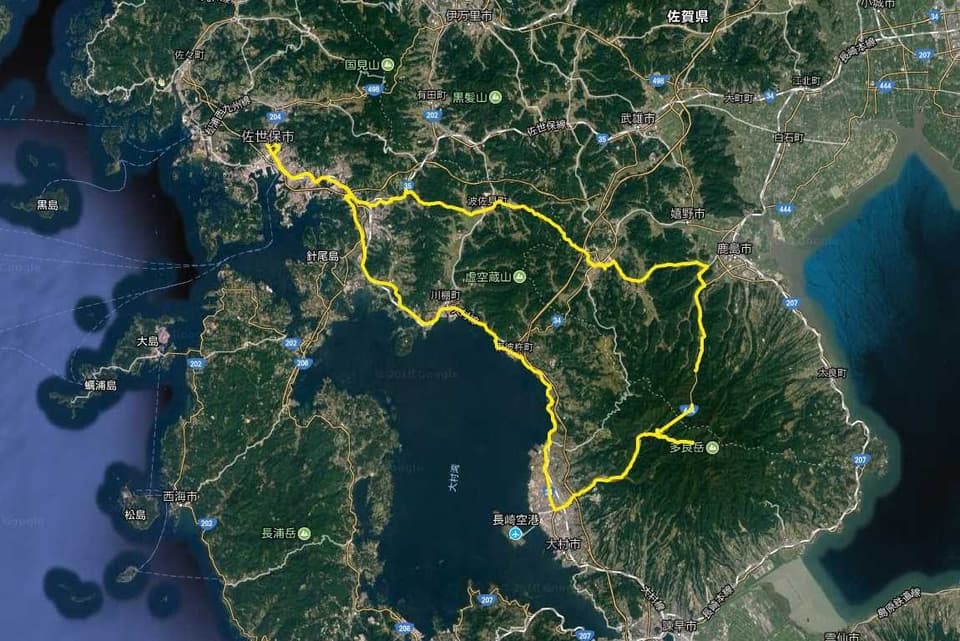

多良岳に行ってきました。

風が強い日でしたが、VRXの練習もかねて多良岳に行ってきました。

一部、GPSをONにし忘れがあって切れています。全体で175kmほど。

嬉野温泉

佐世保→波佐見→嬉野温泉と、強風の中進んでいると小雨が降り出してきました。先日の旅行でお世話になった宿で暖いコーヒーを買って休憩。風速7、8メートルの日はVRXでも突風に煽られそうになりますね。注意が大事です。

中木庭ダム

嬉野温泉→鹿島市経由で、多良岳山系に登ります。途中にダムがありました。

佐賀県鹿島市と長崎県大村市を結ぶ道なので、大きいトラックもそこそこ走っていました。

お食事処のみの郷

中木庭ダムを過ぎると、今日の昼ごはんスポット。

風と小雨で寒かったので、暖かな店内が落ちつきます。

いち推しは「だご汁」でした。セットで頼みました。暖かくて美味しかったです。

公衆トイレの建物の前にあるベンチで一服していると、猫が飼われていました。 猫を見ていたら小雨がしっかりとした雨になりびしょびしょに。風が強いと天気も変わりやすいです。

多良岳登山道

長いトンネルを抜けて、雨振る中、多良岳の山頂方面に向けて走りました。

進んでいくと道の様子が段々と山道になり、写真の場所で断念。

落葉でほとんど見えない白線と、前方のカーブミラーがあるので車道のようですが…。カブではなくVRXで入っていくと大変なことになりそうです。 ガードレールもない道で、谷の下からは沢の音が聞こえていました。

少し戻ったところにある駐車場・トイレには長崎市内の高校の登山部らしき人がいました。 ここでは小雨どころかバラバラと音を立てて雪が降っています。こんな日に登るのは大変そうです。

写真のシャッターを切る時は、雪や雨が止んでいるタイミングなのでまだ良いですが、なかなかの視界不良続きでした。

黒木町ダム運動公園

吹雪いている山道から逃げるように降りてきました。

山頂付近。真っ白な雲が次から次へと流れていきます。

雪も積もっていますね。もう4月なのに…!

後から聞いた話、佐世保の烏帽子岳(標高568m)でも風とともに雪が降っていたらしいです。

萱瀬ダム

さらに下ったところにあるダムです。下りてくると日が照ってくるというマーフィーの法則。そんなに標高は変わってないんだけどなぁ。

この土日は「風が強いが曇り・晴れ」という予報だったので天気が崩れて残念でした。黒木町でもうちょっとゆっくりしたかったなぁ。 大村市街に下りて、大村湾沿いに佐世保に帰りました。

燃料タンク

アップダウンが多い長崎で大柄な僕が乗っていて、燃費はリッター20kmちょっとをキープしています。

走行距離を撮影。風雨風雪にあたったため、汚いです(汗)ちゃんと洗車してあげないと。

この写真を撮った直後に4.1km離れたホームセンターに買い物に行くと、ホームセンターの駐車場まで到着したところでプスプスと音を立てて、駐車枠に入って停車した瞬間アイドリングができずエンスト。 リザーブに切り替えて、隣にあるガソリンスタンドで給油しました。給油量は満タンにして8.51リットルです。

まとめるとこんな感じ。

- 走行距離 178.7km

- 満タン給油量 8.51リットル

- 燃費 21.0km/l

VRXの燃料タンクは11リットルなので、リザーブ容量は2.5リットル。切り替え後も50kmほど走れる計算です。 軽自動車の高速道路での実燃費が20km/l、下道込みの実燃費が15km/l前後なので、高速道路を走り始めると26.25km/lくらいいくのかな。

ツーリングは天気が残念でしたがリザーブタイミングが分かって良かったと思います。

花の森公園に行ってきました。

桜が見頃を迎えた花の森公園に行ってきました。

続きを読む →